大数据视角下的高可用服务器构建全流程

|

在大数据开发工程师的视角下,高可用服务器的构建是一个系统性工程,涉及硬件选型、网络架构、集群部署以及监控体系等多个层面。每一个环节都直接影响到系统的稳定性和数据处理能力。 硬件选型是构建高可用服务器的基础,需要根据业务负载和数据规模选择合适的CPU、内存、存储设备以及网络带宽。同时,冗余设计也是关键,例如采用RAID技术保障磁盘可靠性,配置双电源和双网卡提升容灾能力。 网络架构的设计决定了数据传输的效率与稳定性。在大数据环境中,通常会采用分层网络结构,将计算节点与存储节点分离,并通过高速交换机实现低延迟通信。负载均衡和链路聚合技术可以有效分散流量压力,避免单点故障。 集群部署方面,使用如Hadoop、Spark等分布式框架时,需要合理规划节点数量和角色分配。主从架构、多副本机制以及自动故障转移策略能够显著提升系统的可用性。同时,合理的资源调度和任务分配策略有助于提高整体性能。 监控与告警体系是确保高可用性的关键组成部分。通过Prometheus、Grafana等工具实时采集系统指标,结合Zabbix或ELK日志分析平台,可以及时发现潜在问题并进行预警。自动化运维手段如Ansible或Chef也能大幅减少人工干预,提高响应速度。

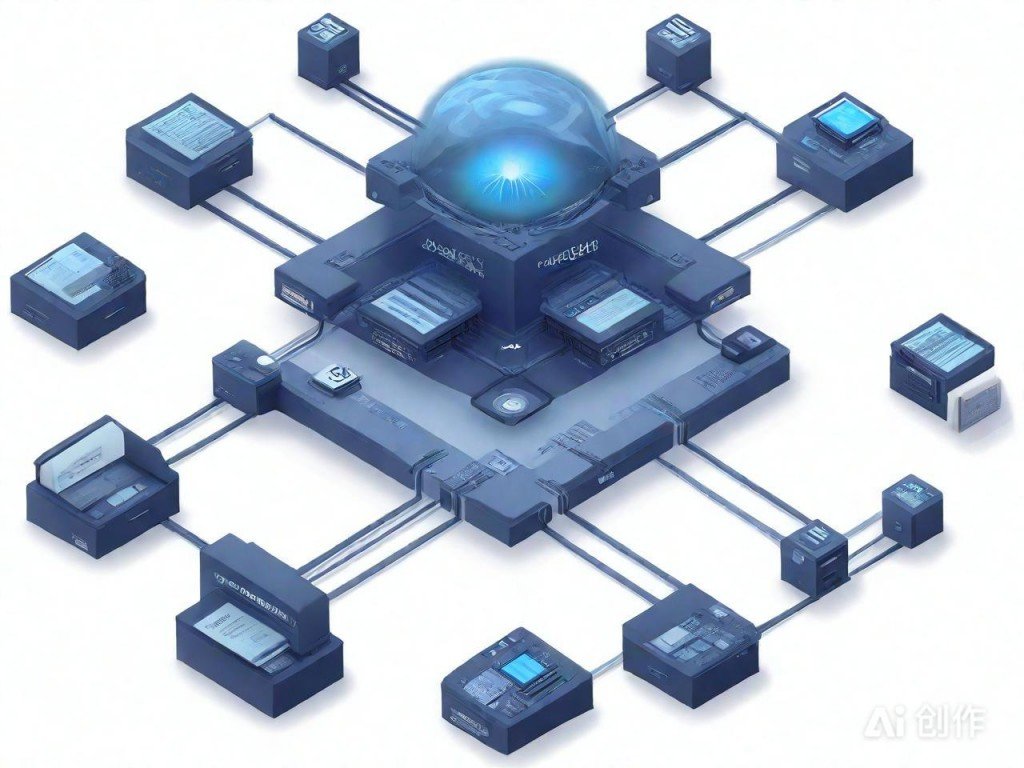

AI模拟效果图,仅供参考 定期进行压力测试和灾难恢复演练,验证系统的健壮性与恢复能力,是持续优化高可用服务器的重要环节。只有不断迭代和完善,才能应对日益增长的数据量和业务复杂度。(编辑:91站长网) 【声明】本站内容均来自网络,其相关言论仅代表作者个人观点,不代表本站立场。若无意侵犯到您的权利,请及时与联系站长删除相关内容! |